Im Germanischen Nationalmuseum in Nürnberg fand die sehr gelungene Ausstellung „Hello Nature – Wie wollen wir zusammen leben?“ statt (03.10.2024 – 02.03.2025). Dabei geht es um die Geschichte der Mensch-Natur-Beziehung und es wird dargestellt, wie der Mensch aus historischer Perspektive die Natur genutzt, beeinflusst und verändert hat.

Am Anfang des Ausstellungsteils „Bedrohung“ werden in einer Laufschrift historische Prophezeiungen für den Weltuntergang angezeigt, die u.a. folgenden Eintrag beinhaltet:

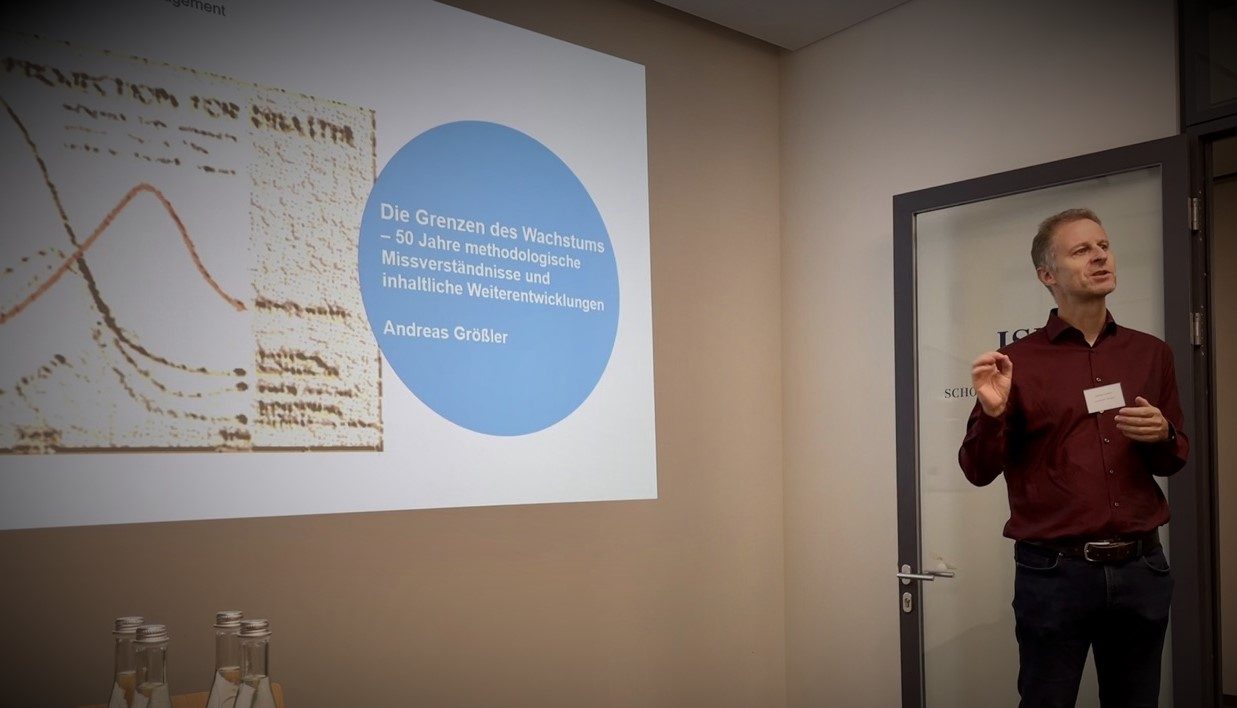

Es wird also gesagt, dass das Massachussetts Institute of Techology (MIT) in den 1970er-Jahren das Ende der Welt für die Zeit ab 2040 vorausgesagt hat (was rein mathematisch gesehen mit großer Sicherheit stimmt). Es wird nicht ausdrücklich erwähnt, aber ich gehe davon aus, dass hier Bezug auf die Grenzen-des-Wachstums-Studie von Meadows u.a. genommen wird (1972). Das irritiert an der ansonsten hervorragenden Ausstellung dann aus zumindest drei Gründen doch (weiteres methodologisches Fehlverständnis habe ich bereits hier und hier besprochen):

Erstens (und auf den Bildern nicht ersichtlich) wird Limits-to-Growth hier in eine recht beliebige Reihe mit teils sehr esoterischen Untergangsprophezeiungen gestellt. Die verwendete Methodik der Studie und die in der Modellierung verwendeten Annahmen sind aber transparent und dadurch kritisierbar (was ja auch in großem Umfang stattgefunden hat). Es handelt sich also bei Limits-to-Growth um eine wissenschaftliche Herangehensweise, im Gegensatz zu rein subjektiven Empfindungen von Untergangspropheten.

Zweitens werden in der Studie nicht Prognosen, sondern Szenarien widergegeben: bei gegebenen Annahmen werden sich die untersuchten Zielgroßen (z.B. Bevölkerung, Ressourcenverfügbarkeit oder wirtschaftliche Situation) über die Zeit in einer bestimmten Weise entwickeln. Dabei werden insgesamt zwölf solcher Szenarien diskutiert und nicht alle können als katastrophal interpretiert werden.

Und drittens, geht es bei den Grenzen-des-Wachstums natürlich nicht um den Untergang der Welt, sondern wie und in welcher Weise menschliche Zivilisation möglich sein wird. Wenn die Szenarien der Studie also mit dem astronomisch berechneten Ende unseres Sonnensystems verglichen werden (das noch mehrere Milliarden Jahre bestehen wird), ist das irreführend.

Im online Open-Access verfügbaren Katalog zur Ausstellung findet sich die Lichtinstallation im Übrigen nicht. Hier wird auf S. 264 korrekt und fundiert der Bezug zur Limits-to-Growth-Studie hergestellt.